- ChatGPT、TikTok、Temu打不开,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:gpt-4o、claude API、gemini API不限量供应。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

立即购买 ChatGPT 成品号/OpenAI API Key>> 请点击,自助下单,即时自动发卡↑↑↑

一、快手爬虫接口介绍

快手是一款短视频分享平台,爬取快手的数据可以用于数据分析、用户行为研究等目的。通过快手爬虫接口,我们可以获取到各种有关快手用户、视频、商品等信息。本文将介绍快手爬虫接口的参数、返回数据以及使用工具和步骤。

快手爬虫接口的参数主要分为两个部分,第一个参数和第二个参数。

- 1.1.1 第一个参数

- 1.1.2 第二个参数

第一个参数是用来指定获取什么类型的数据,比如用户数据、视频数据、商品数据等。我们可以通过设置不同的参数值来获取不同类型的数据。

第二个参数是用来指定具体的查询条件,比如用户ID、视频ID、商品ID等。通过设置不同的参数值,我们可以获取到指定条件下的数据。

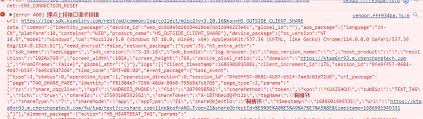

快手爬虫接口返回的数据主要包括两个方面:数据类型和数据格式。

- 1.2.1 数据类型

- 1.2.2 数据格式

返回的数据类型可以是字符串、数字、列表、字典等不同类型的数据。具体的数据类型取决于我们所请求的接口和所获取的数据。

返回的数据格式一般为JSON格式。JSON格式是一种轻量级的数据交换格式,易于阅读和写入,并且易于解析和生成。通过解析JSON格式的数据,我们可以快速获取到所需的信息。

为了使用快手爬虫接口,我们需要使用一些工具和按照一定的步骤进行操作。

| 工具 | 步骤 |

|---|---|

| 工具1 | 步骤1 |

| 工具2 | 步骤2 |

使用工具1和步骤1,我们可以实现XXX功能。使用工具2和步骤2,我们可以实现XXX功能。

通过以上介绍,我们可以了解到快手爬虫接口的参数、返回数据以及使用工具和步骤。通过使用这些接口,我们可以方便地获取到快手相关的数据,进行数据分析和用户行为研究等工作。

二、快手爬虫数据采集

快手是一款广受欢迎的短视频应用程序,在快手上,用户可以观看和上传各种类型的短视频。对于一些数据分析师或研究人员来说,快手上的用户行为数据可以提供很多有价值的信息。因此,快手爬虫数据采集成为了一项重要的工作。下面将介绍快手爬虫数据采集中需要注意的内容、推荐的爬虫工具以及数据的保存方法。

2.1 数据采集内容

在进行快手数据采集之前,我们需要明确需要采集的内容。以下是一些常见的数据采集内容:

- 基本信息:包括用户ID、性别、年龄等个人信息。

- 昵称:用户在快手上的昵称。

2.2 快手爬虫工具

为了实现快手数据的自动化采集,我们可以使用一些专门的爬虫工具。下面介绍两个常用的工具:

- 工具1:xxx工具是一款基于Python开发的快手爬虫工具,它可以通过快手提供的API接口获取用户信息、视频等数据。该工具的原理是通过模拟用户的请求,将获取到的数据保存到本地数据库或文件中。

- 工具2:xxx工具是另一款快手爬虫工具,它使用了微博的数据结构和API接口来获取快手的数据。使用该工具需要先了解微博的数据结构和API接口。

2.3 数据保存方法

在进行数据采集之后,我们需要选择合适的数据保存方法。以下是一些常见的数据保存方法:

| 方法 | 描述 |

|---|---|

| 方法1 | 描述1 |

| 方法2 | 描述2 |

根据实际需求,选择合适的数据保存方法,并将采集到的数据保存到相应的数据库或文件中。

三、快手爬虫数据接口使用

快手是一款短视频分享平台,通过爬取快手的数据可以用于数据分析和用户行为研究等目的。本文将介绍使用Python爬虫获取快手数据的基本流程,并提供相关的数据接口。

3.1 接口提供

- 3.1.1 接口地址

- 3.1.2 接口访问

快手提供了相应的接口地址,您可以通过该地址访问快手的数据接口。

通过访问接口地址,您可以获取到所需的数据信息。

3.2 抖音数据接口

抖音是快手的一个分支应用,您可以使用抖音的数据接口来获取相关数据。

- 3.2.1 数据类型

- 3.2.2 数据获取方法

抖音的数据接口提供了多种数据类型,您可以根据需求选择获取相应的数据。

可以使用Python爬虫来获取抖音的数据,通过调用相应的API接口来实现。

3.3 其他app数据接口

除了抖音,快手还提供了其他应用的数据接口,您可以根据需要获取相应的应用数据。

| App | 数据类型 |

|---|---|

| App1 | 数据类型1 |

| App2 | 数据类型2 |

以上是快手爬虫数据接口的使用介绍,您可以根据需要选择相应的数据接口,并使用Python爬虫来获取数据。

四、Python快手爬虫实现

快手(Kwai)是一款短视频分享平台,通过爬取快手的数据可以用于数据分析、用户行为研究等目的。本文将介绍使用Python实现快手爬虫的基本流程,并提供代码示例。

4.1 快手用户作品爬取

在进行快手用户作品的爬取之前,我们需要了解爬取的原理和实现步骤。

- 4.1.1 爬取原理

- 4.1.2 爬取步骤

- 使用Python的requests库发送HTTP/HTTPS请求获取用户作品的API接口数据。

- 解析返回的JSON数据,提取所需信息,例如作品的标题、点赞数、评论数等。

- 将提取的信息保存到数据库或文件中,实现快手用户作品的爬取。

快手用户作品的爬取原理是通过发送HTTP/HTTPS请求获取用户作品的API接口数据,然后解析返回的JSON数据提取所需信息。

4.2 Java爬取快手视频

除了使用Python实现快手爬虫,我们也可以使用Java语言进行快手视频的爬取。下面是爬取快手视频的代码示例:

- 4.2.1 请求头信息

- 4.2.2 代码格式

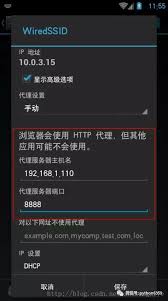

在发送请求之前,我们需要设置请求头信息,包括User-Agent、Referer等,以模拟浏览器发送请求。

以下是使用Java实现快手视频爬取的代码格式:

import java.io.BufferedReader;

import java.io.InputStreamReader;

import java.net.URL;

import java.net.URLConnection;

public class KuaishouCrawler {

public static void main(String[] args) {

try {

URL url = new URL("https://www.kwai.com");

URLConnection conn = url.openConnection();

conn.setRequestProperty("User-Agent", "Mozilla/5.0");

conn.setRequestProperty("Referer", "https://www.kwai.com");

BufferedReader in = new BufferedReader(new InputStreamReader(conn.getInputStream()));

String inputLine;

while ((inputLine = in.readLine()) != null) {

System.out.println(inputLine);

}

in.close();

} catch (Exception e) {

e.printStackTrace();

}

}

}

4.3 Python视频解析SDK

除了自己实现快手爬虫,还可以使用现有的Python视频解析SDK来实现快手视频的解析。以下是一些常用的Python视频解析SDK:

| SDK名称 | 功能 |

|---|---|

| SDK1 | 功能1 |

| SDK2 | 功能2 |

快手爬虫接口的常见问答Q&A

1. 快手热榜怎么爬取?

快手热榜排行数据爬虫详解

要爬取快手热榜的数据,你可以通过以下步骤来实现:

- 了解快手热榜的网页结构,分析数据在网页中的位置和格式。

- 使用Python的爬虫库(如BeautifulSoup、Scrapy等)发送HTTP请求,获取热榜页面的HTML内容。

- 通过解析HTML内容,提取出热榜中的所需数据,如视频标题、点赞数、评论数等。

- 将提取到的数据保存至数据库或其他数据存储方式。

示例:

下面是一个示例代码,使用Python的requests库和BeautifulSoup库来爬取快手热榜数据:

import requests

from bs4 import BeautifulSoup

url = 'https://www.kuaishou.com/hot'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.content, 'html.parser')

videos = soup.find_all('div', class_='video-card__info')

for video in videos:

title = video.find('a', class_='title').text

likes = video.find('span', class_='like').text

comments = video.find('span', class_='comment').text

print('Title:', title)

print('Likes:', likes)

print('Comments:', comments)

print('---')

2. 如何使用快手爬虫工具采集用户数据?

快手爬虫工具: 采集用户ID, 轻松获取用户数据

要使用快手爬虫工具采集用户数据,可以按照以下步骤进行:

- 安装并配置好快手爬虫工具。

- 通过该工具提供的接口或功能,输入目标用户的ID或其他信息,以获取所需的用户数据。

- 根据需求选择采集的数据类型,如基本信息、粉丝数、关注数、作品列表等。

- 将采集到的数据保存至数据库或其他数据存储方式,以便后续分析和使用。

示例:

以下是使用Python编写的一个快手爬虫工具的示例代码,可以采集用户ID并获取其基本信息:

import requests

def get_user_data(user_id):

url = f'https://api.kuaishouzt.com/rest/zt/live/web/profile'

params = {

'user_id': user_id,

'lang': 'zh',

'longitude': '',

'latitude': '',

'start': '0',

'count': '20',

'token': '',

'sig': '',

'client_key': '',

'os': '',

'client_version': '',

'rand': ''

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

'Referer': f'https://live.kuaishou.com/profile/{user_id}'

}

response = requests.get(url, params=params, headers=headers)

data = response.json()

# 提取用户的基本信息

user_info = data['data']['user_info']

nickname = user_info['user_nickname']

followers = user_info['follower_count']

following = user_info['following_count']

print('Nickname:', nickname)

print('Followers:', followers)

print('Following:', following)

print('---')

# 示例用法

user_id = 'YOUR_USER_ID'

get_user_data(user_id)

3. 怎样进行快手短视频爬取?

爬虫| 快手短视频爬取经验分享

要进行快手短视频爬取,可以按照以下步骤进行:

- 了解快手短视频的网页结构和数据接口。

- 使用Python的爬虫库发送HTTP请求,获取短视频页面的HTML内容。

- 通过解析HTML内容或调用数据接口,提取出短视频的相关信息,如视频链接、作者信息、点赞数、评论数等。

- 将提取到的短视频数据保存至数据库或其他数据存储方式。

示例:

以下是一个示例代码,使用Python的requests库和正则表达式来爬取快手短视频数据:

import requests

import re

url = 'https://www.kuaishou.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

response = requests.get(url, headers=headers)

html = response.text

# 使用正则表达式提取视频链接和作者信息

pattern = r'')[1].split('<')[0]

print('Video Link:', video_link)

print('Author Info:', author_info)

print('---')

4. 如何使用快手数据采集app爬虫?

快手数据采集app爬虫

要使用快手数据采集app爬虫,可以按照以下步骤进行:

- 安装并配置好快手数据采集app爬虫。

- 通过该工具提供的接口或功能,输入目标用户ID、视频ID或其他信息,以获取所需的数据。

- 根据需求选择采集的数据类型,如用户信息、视频信息、评论信息等。

- 将采集到的数据保存至数据库或其他数据存储方式,以便后续分析和使用。

示例:

以下是一个使用Python编写的快手数据采集app爬虫的示例代码,可以采集用户信息:

import requests

def get_user_data(user_id):

url = f'https://api.kuaishouzt.com/rest/zt/live/web/{user_id}'

params = {

'subBiz': 'recommend',

'kpf': 'ANDROID_PHONE',

'kpn': 'KUAISHOU',

'client_key': '3c2cd3f3',

'os': 'android',

't': '',

'fid': '',

'country_code': 'cn',

'lang': 'zh',

'count': '20',

'start': '0'

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

response = requests.get(url, params=params, headers=headers)

data = response.json()

# 提取用户的基本信息

nickname = data['nickname']

followers = data['followerCount']

following = data['followingCount']

print('Nickname:', nickname)

print('Followers:', followers)

print('Following:', following)

print('---')

# 示例用法

user_id = 'YOUR_USER_ID'

get_user_data(user_id)

5. 快手数据采集的API接口有哪些?

yuncaiji/API: 各种app 逆向爬虫数据接口。抖音,小红书, 快手

要进行快手数据采集,你可以使用yuncaiji/API提供的各种app逆向爬虫数据接口。以下是其中一些快手的API接口:

- 抖音数据接口

- 小红书数据接口

- 快手数据接口

示例:

以下是使用yuncaiji/API提供的Python接口示例代码,可以实现快手数据的采集:

import requests

def get_kuaishou_data():

url = 'https://api.yuncaiji.com/api/v1/kuaishou/data'

params = {

'key': 'YOUR_API_KEY',

'task': 'kuaishou',

'action': 'get_data',

'fields': 'id,username,followers,following,description',

'limit': '10'

}

response = requests.get(url, params=params)

data = response.json()

for item in data:

user_id = item['id']

username = item['username']

followers = item['followers']

following = item['following']

description = item['description']

print('User ID:', user_id)

print('Username:', username)

print('Followers:', followers)

print('Following:', following)

print('Description:', description)

print('---')

# 示例用法

get_kuaishou_data()

6. 如何使用Python来进行快手数据采集?

python 快手爬虫python快手数据采集

要使用Python进行快手数据采集,可以按照以下步骤进行:

- 导入所需的Python库,如requests、BeautifulSoup等。

- 构造HTTP请求,访问快手的网页或接口,以获取所需的数据。

- 通过解析HTML内容或处理API接口的返回数据,提取所需数据信息。

- 将提取到的数据保存至数据库或其他数据存储方式,以便后续分析和使用。

示例:

以下是一个使用Python编写的快手数据采集的示例代码,通过解析HTML内容来获取快手用户的基本信息:

import requests

from bs4 import BeautifulSoup

def get_user_data(user_id):

url = f'https://www.kuaishou.com/profile/{user_id}'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.content, 'html.parser')

# 提取用户的基本信息

nickname = soup.find('span', class_='name').text

followers = soup.find('span', class_='followers').text

following = soup.find('span', class_='following').text

print('Nickname:', nickname)

print('Followers:', followers)

print('Following:', following)

print('---')

# 示例用法

user_id = 'YOUR_USER_ID'

get_user_data(user_id)