- ChatGPT、TikTok、Temu打不开,专用网络美国海外专线光纤:老张渠道八折优惠。立即试用>

- GPT3.5普通账号:美国 IP,手工注册,独享,新手入门必备,立即购买>

- GPT-4 Plus 代充升级:正规充值,包售后联系微信:laozhangdaichong7。下单后交付>

- OpenAI API Key 独享需求:gpt-4o、claude API、gemini API不限量供应。立即购买>

- OpenAI API Key 免费试用:搜索微信公众号:紫霞街老张,输入关键词『试用KEY』

立即购买 ChatGPT 成品号/OpenAI API Key>> 请点击,自助下单,即时自动发卡↑↑↑

如何在本地部署ChatGPT 3.5与4.0:详细教程与步骤

说在前面

在当今的人工智能和自然语言处理领域,ChatGPT 无疑是一个备受关注的技术创新。无论是对开发者,还是对企业用户,能够在本地部署ChatGPT 3.5与4.0都是一项极为实用的技能。本篇文章将带您一步一步了解如何在本地成功部署这些强大的语言模型,让您能够充分利用其强大的能力。

部署ChatGPT在本地的重要性不言而喻。这不仅可以保证数据的隐私和安全,同时也能显著提升处理速度和响应能力。对于一些对网络要求较高或需要高可用性的应用场景,本地部署是最佳选择。

在本教程里,您将学习到从环境准备、所需工具安装到具体部署步骤等详细内容。希望这份指南能帮助您顺利完成本地部署,不再为繁琐的安装步骤头疼。

ChatGPT 背景介绍

定义和基本概念

ChatGPT是由OpenAI开发的强大语言模型,能够进行自然语言理解和生成对话。它通过深度学习和庞大的训练数据,模拟人类对话的方式,进行语言生成。ChatGPT 3.5与4.0是其最新版本,前者在性能和速度上进行了显著改进,而后者更是引入了更多先进的特性和更强的生成能力。

历史和发展

自从OpenAI发布其第一代GPT模型以来,该技术发展迅速。GPT-3.5继承了GPT-3的基本架构,但在细节和实现上做了大幅优化,显著提升了语言理解和生成的效果。GPT-4.0则在此基础上进一步改革,通过更多的训练数据和更复杂的算法,实现了更高水平的智能对话。可以说,ChatGPT的发展史也是自然语言处理技术进步的缩影。

ChatGPT 详细解读

步骤一:环境准备

在开始部署之前,首先需要准备好必要的环境。这包括操作系统、相关的编译器和开发工具。一般推荐使用Ubuntu或类似的Linux系统进行部署。

- 操作系统:推荐使用64位的Ubuntu 20.04或以上版本。

- Python环境:确保安装了Python 3.8或以上版本。

- 开发工具:安装Git、Docker等开发工具。

- 硬件要求:至少具备8GB以上的内存,越多越好。

步骤二:安装必要工具

接下来,需要安装部署ChatGPT所需要的各类工具。首先是Python的虚拟环境和相关的依赖库。

- 创建Python虚拟环境:

python3 -m venv myenv - 激活虚拟环境:

source myenv/bin/activate - 安装必要的Python库:

pip install torch transformers

步骤三:下载和配置ChatGPT模型

需要从官方渠道下载ChatGPT 3.5或4.0的模型文件,并进行相应的配置。以下以ChatGPT 4.0为示例。

- 下载模型文件:可以通过OpenAI的官方网站或其提供的API获取模型文件。

- 配置环境变量:确保将模型文件的位置和其他必要的路径添加到系统的环境变量中。

- 初始化模型:使用Python代码载入模型:

from transformers import GPT2LMHeadModel, GPT2Tokenizer以及model = GPT2LMHeadModel.from_pretrained('path/to/model')

步骤四:测试与调试

在完成上述步骤后,可以进行测试。编写简单的脚本,调用模型进行文本生成,确保模型能够正常工作。例如:

import torch

from transformers import GPT2LMHeadModel, GPT2Tokenizer

tokenizer = GPT2Tokenizer.from_pretrained('path/to/tokenizer')

model = GPT2LMHeadModel.from_pretrained('path/to/model')

inputs = tokenizer("你的输入文本", return_tensors='pt')

outputs = model(**inputs)

步骤五:优化与扩展

在基本功能测试通过后,还可以进一步优化模型的性能,或将其集成到更大的系统项目中。需要注意的是,特定的应用场景可能需要进行进一步的微调和优化。

ChatGPT 相关Tips

- 硬件优化:使用GPU可以显著提高模型的运行速度。如果条件允许,建议配置支持CUDA的显卡。

- 缓存机制:对于频繁调用的应用场景,设置合理的缓存机制可以提高响应速度并减少计算资源消耗。

- 分布式部署:对于高并发请求,可以考虑使用多节点分布式部署,以提高处理能力。

常见问题解答(FAQ)

1. ChatGPT本地部署需要多长时间?

这取决于硬件配置和网络条件。通常情况下,整个部署过程大约需要几小时到一天的时间。

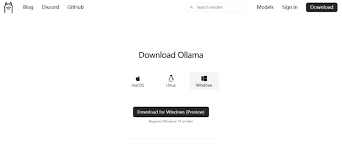

2. 我可以在Windows系统上部署ChatGPT吗?

可以,但Linux系统通常更加方便且高效。对于Windows用户,建议使用WSL(Windows Subsystem for Linux)进行部署。

3. 部署后的模型可以进行更新吗?

可以。OpenAI会定期发布模型更新,您可以下载最新的模型文件并进行相应的配置即可。

总结

在本文中,我们详细介绍了如何在本地部署ChatGPT 3.5与4.0,涵盖了从环境准备、工具安装到具体配置及测试的各个步骤。这一过程虽然需要一定的技术基础,但通过本文的指导,相信您可以轻松完成部署。

再次强调,在本地部署ChatGPT不仅能提升应用性能,还可以更好地保护数据隐私。希望本教程能帮助您顺利实现ChatGPT本地化部署,并充分利用其强大的语言生成能力。下一步,您可以尝试将其与现有业务系统集成,进一步发挥其价值。